Hacer que los agentes de inteligencia artificial aprendan a jugar videojuegos simples es una forma ideal de probar su efectividad, gracias a la capacidad de medir el éxito a través de una puntuación.

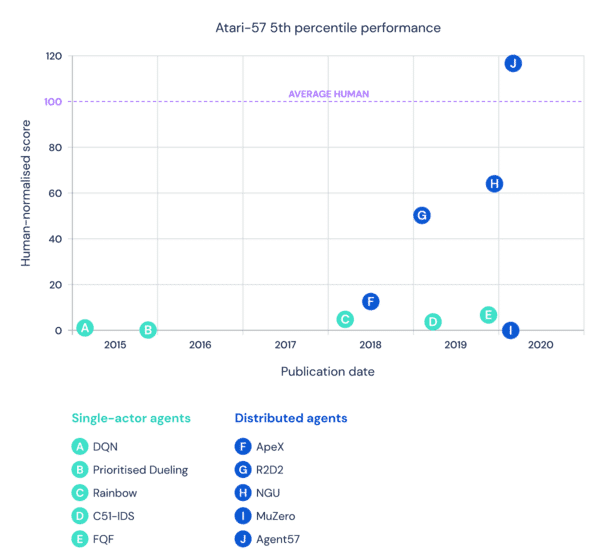

DeepMind de Alphabet designó 57 juegos particulares de Atari para que sirvieran como prueba de fuego para su IA, y estableció un punto de referencia para las habilidades de un jugador humano promedio. El último sistema de la compañía, Agent57, dio un gran salto sobre los sistemas anteriores, y es la primera iteración de la IA que supera a la línea de base humana. En particular, Agent57 ha demostrado sus habilidades sobrehumanas en Pitfall, Montezuma’s Revenge, Solaris y Skiing, juegos que han sido desafíos importantes para otras IA.

no posts foundDe acuerdo con Technology Review del MIT, Pitfall y Montezuma’s Revenge requieren que la IA experimente más de lo habitual para descubrir cómo obtener una mejor puntuación. Mientras tanto, Solaris y Skiing son difíciles para la IA porque no hay tantos indicios como éxito: la IA no sabe si está haciendo los movimientos correctos durante largos períodos de tiempo. DeepMind se basó en sus agentes de inteligencia artificial más antiguos para que Agent57 pudiera tomar mejores decisiones con respecto a la exploración y la explotación de puntajes, así como para optimizar la compensación entre el rendimiento a corto y largo plazo en juegos como Skiing.

Technology Review señala que si bien estos resultados son impresionantes, AI todavía tiene un largo camino por recorrer. Estos sistemas solo pueden descubrir un juego a la vez, lo que dice que está en desacuerdo con las habilidades de los humanos:

«La verdadera versatilidad, que es tan fácil para un bebé humano, todavía está mucho más allá del alcance de la IA».

Dicho esto, la IA ya está en uso en todas las industrias. Las lecciones aprendidas de Agent57 podrían ayudar a mejorar el rendimiento, incluso si las habilidades a nivel humano no son alcanzables por ahora.