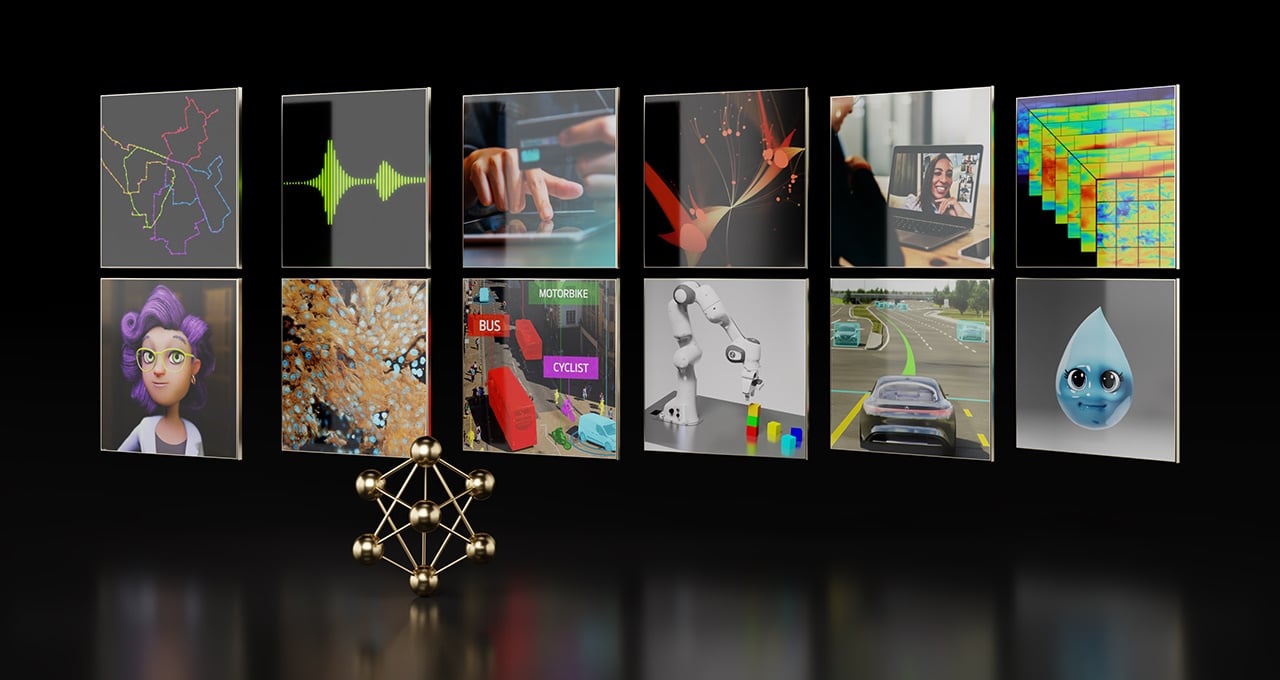

Nvidia lanzó docenas de microservicios de IA generativa de nivel empresarial que las empresas pueden utilizar para crear e implementar aplicaciones personalizadas en sus propias plataformas mientras conservan la propiedad y el control total de su propiedad intelectual.

Construido sobre la plataforma Nvidia CUDA, el catálogo de microservicios nativos de la nube incluye Nvidia NIM para la inferencia optimizada en más de dos docenas de modelos populares de IA de Nvidia y su ecosistema de socios. Además, ahora se puede acceder a los kits, bibliotecas y herramientas de desarrollo de software acelerado de Nvidia como microservicios Nvidia CUDA-X para generación aumentada de recuperación (RAG), barreras de seguridad, procesamiento de datos, HPC y más. NVIDIA también anunció por separado más de dos docenas de microservicios NIM y CUDA-X para atención médica.

no posts foundLa selección curada de microservicios agrega una nueva capa a la plataforma informática de pila completa de Nvidia. Esta capa conecta el ecosistema de IA de desarrolladores de modelos, proveedores de plataformas y empresas con una ruta estandarizada para ejecutar modelos de IA personalizados optimizados para la base instalada de CUDA de Nvidia de cientos de millones de GPU en nubes, centros de datos, estaciones de trabajo y PC.

Entre los primeros en acceder a los nuevos microservicios de IA generativa de Nvidia disponibles en Nvidia AI Enterprise 5.0 se encuentran los principales proveedores de plataformas de aplicaciones, datos y ciberseguridad, incluidos Adobe, Cadence, CrowdStrike, Getty Images, SAP, ServiceNow y Shutterstock.

“Las plataformas empresariales establecidas cuentan con una mina de oro de datos que pueden transformarse en copilotos de IA generativa”, afirma Jensen Huang, fundador y director ejecutivo de Nvidia. “Creados con nuestro ecosistema de socios, estos microservicios de IA en contenedores son los pilares para que las empresas de todos los sectores se conviertan en empresas de IA”.

Los microservicios de inferencia NIM aceleran las implementaciones de semanas a minutos

Los microservicios NIM proporcionan contenedores prediseñados con tecnología de software de inferencia Nvidia, incluidos Triton Inference Server y TensorRT-LLM, que permiten a los desarrolladores reducir los tiempos de implementación de semanas a minutos.

Proporcionan API estándar de la industria para dominios como el lenguaje, el habla y el descubrimiento de fármacos para permitir a los desarrolladores crear rápidamente aplicaciones de IA utilizando sus datos patentados alojados de forma segura en su propia infraestructura. Estas aplicaciones pueden ampliarse a medida que se necesiten, lo que proporciona flexibilidad y rendimiento para ejecutar IA generativa en producción en plataformas informáticas aceleradas por Nvidia.

Los microservicios NIM proporcionan el contenedor de IA de producción más rápido y de mayor rendimiento para implementar modelos de Nvidia, A121, Adept, Cohere, Getty Images y Shutterstock, así como modelos abiertos de Google, Hugging Face, Meta, Microsoft, Mistral AI y Stability AI.

ServiceNow anunció hoy que está utilizando NIM para desarrollar e implementar nuevos copilotos de dominio específico y otras aplicaciones de IA generativa de manera más rápida y rentable.

Los clientes tendrán acceso a microservicios NIM de Amazon SageMaker, Google Kubernetes Engine y Microsoft Azure AI, e integrarse a marcos de IA populares, como Deepset, LangChain y LlamaIndex.

«Los microservicios de IA generativa son una innovación ágil y personalizada. A través de esta tecnología, los desarrolladores tienen el poder de dar forma al futuro de las aplicaciones empresariales y podrán ayudar a las empresas en la revolución de la IA», afirma Marcio Aguiar, director de la división Enterprise de Nvidia para América Latina.

Microservicios CUDA-X para RAG, procesamiento de datos, Guardrails, HPC

Los microservicios CUDA-X proporcionan componentes básicos de extremo a extremo para la preparación, personalización y entrenamiento de datos con el fin de acelerar el desarrollo de la IA de producción en todas las industrias.

Para acelerar la adopción de la IA, las empresas pueden utilizar los microservicios CUDA-X, incluidos Nvidia Riva para una IA de voz y traducción personalizable, Nvidia cuOpt para optimización de enrutamiento, y Nvidia Earth-2 para simulaciones climáticas y meteorológicas de alta resolución.

Los microservicios NeMo Retriever permiten a los desarrolladores vincular sus aplicaciones de IA con sus datos comerciales (incluidos texto, imágenes y visualizaciones como gráficos de barras, diagramas de líneas y gráficos circulares) para generar respuestas muy precisas y adaptadas al contexto. Con estas capacidades de RAG, las empresas pueden ofrecer más datos a copilotos, chatbots y herramientas de productividad de IA generativa para elevar la precisión y el conocimiento.

Próximamente estarán disponibles más microservicios Nvidia NeMo para el desarrollo de modelos personalizados. Estos incluyen Nvidia NeMo Curator para crear conjuntos de datos limpios para entrenamiento y recuperación, Nvidia NeMo Customizer para ajustar los LLM con datos específicos del dominio, Nvidia NeMo Evaluator para analizar el rendimiento del modelo de IA, así como Nvidia NeMo Guardrails para LLM.

El ecosistema potencia las plataformas empresariales con microservicios de IA generativa

Además de los principales proveedores de aplicaciones, los proveedores de plataformas informáticas, de datos y de infraestructura en todo el ecosistema de Nvidia están trabajando con los microservicios de Nvidia para llevar la IA generativa a las empresas.

Los principales proveedores de plataformas de datos, incluidos Box, Cloudera, Cohesity, Datastax, Dropbox y NetApp están trabajando con los microservicios de Nvidia para ayudar a los clientes a optimizar sus canales RAG e integrar sus datos patentados en aplicaciones generativas de IA. Snowflake aprovecha NeMo Retriever para manejar datos empresariales para la creación de aplicaciones de IA.

Las empresas pueden implementar microservicios de Nvidia incluidos con Nvidia AI Enterprise 5.0 en la infraestructura de su elección, como las nubes líderes Amazon Web Services (AWS), Google Cloud, Azure y Oracle Cloud Infrastructure.

Los microservicios NVIDIA también son compatibles con más de 400 NVIDIA-Certified Systems, iincluidos servidores y estaciones de trabajo de Cisco, Dell Technologies, Hewlett Packard Enterprise (HPE), HP, Lenovo y Supermicro. Por otra parte, HPE anunció hoy la disponibilidad de la solución informática empresarial de HPE para IA generativa, con la integración planificada de los modelos NIM y Nvidia AI Foundation en el software de IA de HPE.

Los microservicios Nvidia AI Enterprise están llegando a plataformas de software de infraestructura, incluidaVMware Private AI Foundation con Nvidia. Red Hat OpenShift admite los microservicios NIM de Nvidia para ayudar a las empresas a integrar más fácilmente capacidades de IA generativa en sus aplicaciones con capacidades optimizadas de seguridad, cumplimiento y controles. Canonical está agregando compatibilidad con Charmed Kubernetes para los microservicios de Nvidia a través de NVIDIA AI Enterprise.

El ecosistema de Nvidia de cientos de socios de IA y MLOps, incluidos Abridge, Anyscale, Dataiku, DataRobot, Glean, H2O.ai, Securiti AI, Scale.ai, OctoAI y Weights & Biases, están agregando soporte para los microservicios de Nvidia a través de Nvidia AI Enterprise.

Apache Lucene, Datastax, Faiss, Kinetica, Milvus, Redis y Weaviate se encuentran entre los proveedores de búsqueda vectorial que trabajan con los microservicios Nvidia NeMo Retriever para potenciar las capacidades RAG de respuesta para empresas.

Disponbilidad

Los desarrolladores pueden experimentar con los microservicios de Nvidia en ai܂nvidia܂com sin costo alguno. Las empresas pueden implementar microservicios NIM de nivel de producción con Nvidia AI Enterprise 5.0 ejecutándose en sistemas certificados por Nvidia y plataformas de nube líderes.